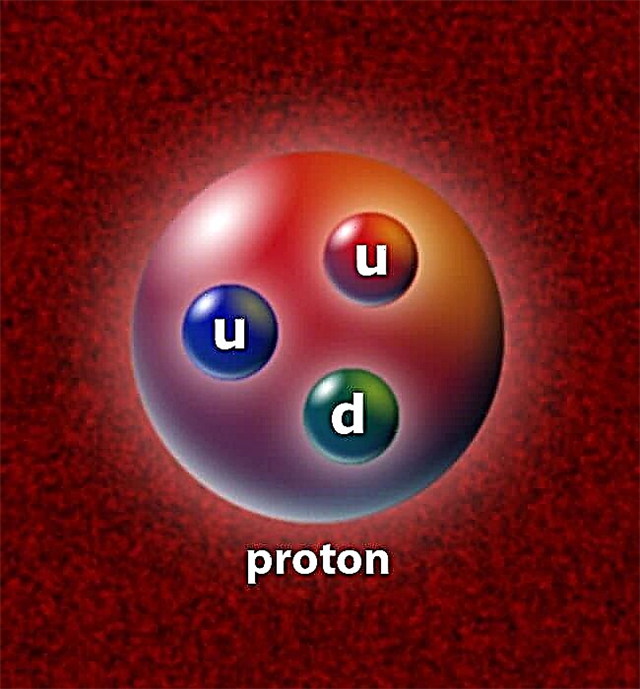

Wir wissen bereits, dass der Large Hadron Collider (LHC) das größte und teuerste physikalische Experiment sein wird, das jemals von der Menschheit durchgeführt wurde. Kollidierende relativistische Partikel bei Energien, die bisher unvorstellbar waren (bis zur 14-TeV-Marke bis zum Ende des Jahrzehnts), erzeugen Millionen von Partikeln (bekannt und noch zu entdecken), die von riesigen Partikeldetektoren verfolgt und charakterisiert werden müssen. Dieses historische Experiment erfordert einen massiven Aufwand für die Datenerfassung und -speicherung, bei dem die Regeln für die Datenverarbeitung neu geschrieben werden. Alle fünf Sekunden erzeugen LHC-Kollisionen das Äquivalent einer Datenmenge im DVD-Wert, dh eine Datenproduktionsrate von einem Gigabyte pro Sekunde. Um dies ins rechte Licht zu rücken, kann ein durchschnittlicher Haushaltscomputer mit einer sehr guten Verbindung möglicherweise Daten mit einer Geschwindigkeit von ein oder zwei Megabyte pro Sekunde herunterladen (wenn Sie sehr viel Glück haben! Ich bekomme 500 Kilobyte / Sekunde). Daher haben LHC-Ingenieure eine neue Art der Datenverarbeitungsmethode entwickelt, die gespeichert und verteilt werden kann Petabyte (Millionen Gigabyte) von Daten an LHC-Mitarbeiter weltweit (ohne alt und grau zu werden, während auf einen Download gewartet wird).

1990 hat die Europäische Organisation für Kernforschung (CERN) unsere Lebensweise revolutioniert. Im Vorjahr schrieb Tim Berners-Lee, ein CERN-Physiker, einen Vorschlag für ein elektronisches Informationsmanagement. Er vertrat die Idee, dass Informationen mithilfe von „Hypertext“ einfach über das Internet übertragen werden könnten. Im Laufe der Zeit bauten Berners-Lee und der ebenfalls am CERN tätige Systemingenieur Robert Cailliau ein einziges Informationsnetzwerk zusammen, um den Wissenschaftlern des CERN die Zusammenarbeit und den Austausch von Informationen von ihren PCs zu erleichtern, ohne sie auf umständlichen Speichergeräten speichern zu müssen. Mit Hypertext konnten Benutzer Text über Webseiten mit durchsuchen und freigeben Hyperlinks. Anschließend erstellte Berners-Lee einen Browser-Editor und erkannte bald, dass diese neue Form der Kommunikation von einer großen Anzahl von Menschen geteilt werden konnte. Bis Mai 1990 nannten die CERN-Wissenschaftler dieses neue kollaborative Netzwerk das Weltweites Netz. Tatsächlich war CERN für die weltweit erste Website verantwortlich: http://info.cern.ch/. Ein frühes Beispiel dafür, wie diese Website aussah, finden Sie auf der Website des World Wide Web Consortium.

Das CERN ist also kein Unbekannter bei der Verwaltung von Daten über das Internet, aber der brandneue LHC erfordert eine besondere Behandlung. Wie David Bader, Executive Director für Hochleistungsrechnen am Georgia Institute of Technology, hervorhob, ist die derzeit vom Internet zugelassene Bandbreite ein großer Engpass, der andere Formen des Datenaustauschs wünschenswerter macht. „Wenn ich mir den LHC anschaue und weiß, was er für die Zukunft tut, ist das einzige, was das Web nicht konnte, eine phänomenale Datenfülle zu verwalten", Sagte er, was bedeutet, dass es einfacher ist, große Datenmengen auf Terabyte-Festplatten zu speichern und sie dann per Post an Mitarbeiter zu senden. Obwohl sich das CERN mit dem kollaborativen Charakter des Datenaustauschs im World Wide Web befasst hat, werden die vom LHC generierten Daten die derzeit verfügbaren kleinen Bandbreiten leicht überlasten.

Aus diesem Grund wurde das LHC Computing Grid entwickelt. Das Raster verarbeitet die Produktion großer LHC-Datensätze in Ebenen, die erste (Tier 0) befindet sich vor Ort am CERN in der Nähe von Genf, Schweiz. Tier 0 besteht aus einem riesigen parallelen Computernetzwerk mit 100.000 fortschrittlichen CPUs, die so eingerichtet wurden, dass die vom LHC gepumpten Rohdaten (1 und 0 Binärcode) sofort gespeichert und verwaltet werden. An dieser Stelle ist anzumerken, dass nicht alle Partikelkollisionen von den Sensoren erfasst werden, sondern nur ein sehr kleiner Teil erfasst werden kann. Obwohl nur eine vergleichsweise geringe Anzahl von Partikeln nachgewiesen werden kann, führt dies immer noch zu einer enormen Leistung.

Tier 0 verwaltet Teile der ausgegebenen Daten, indem sie über dedizierte Glasfaserleitungen mit 10 Gigabit pro Sekunde auf 11 übertragen werden Tier 1 Standorte in Nordamerika, Asien und Europa. Auf diese Weise können Mitarbeiter wie der Relativistic Heavy Ion Collider (RHIC) am Brookhaven National Laboratory in New York Daten aus dem ALICE-Experiment analysieren und die Ergebnisse der LHC-Bleiionenkollisionen mit ihren eigenen Schwerionenkollisionsergebnissen vergleichen.

Von den internationalen Tier 1-Computern werden Datensätze gepackt und an 140 gesendet Rang 2 Computernetzwerke an Universitäten, Labors und privaten Unternehmen auf der ganzen Welt. An diesem Punkt haben Wissenschaftler Zugriff auf die Datensätze, um die Umwandlung des rohen Binärcodes in verwendbare Informationen über Teilchenenergien und -trajektorien durchzuführen.

Das Tier-System ist alles in Ordnung und gut, aber ohne eine hocheffiziente Art von Software namens "Middleware" würde es nicht funktionieren. Beim Versuch, auf Daten zuzugreifen, möchte der Benutzer möglicherweise Informationen, die über die Petabyte an Daten auf verschiedenen Servern in verschiedenen Formaten verteilt sind. Eine Open-Source-Middleware-Plattform namens Globus wird die große Verantwortung haben, die erforderlichen Informationen nahtlos zu sammeln, als ob diese Informationen bereits im Computer des Forschers gespeichert wären.

Diese Kombination aus Tier-System, schneller Verbindung und ausgeklügelter Software könnte über das LHC-Projekt hinaus erweitert werden. In einer Welt, in der alles „on demand“ wird, könnte diese Art von Technologie das Internet machen transparent an den Endbenutzer. Es würde sofortigen Zugriff auf alles geben, von Daten, die durch Experimente auf der anderen Seite des Planeten erzeugt wurden, bis hin zum Anzeigen von hochauflösenden Filmen, ohne auf den Fortschrittsbalken für den Download zu warten. Ähnlich wie Berners-Lees Erfindung von HTML könnte das LHC Computing Grid die Nutzung des Internets revolutionieren.

Quellen: Scientific American, CERN